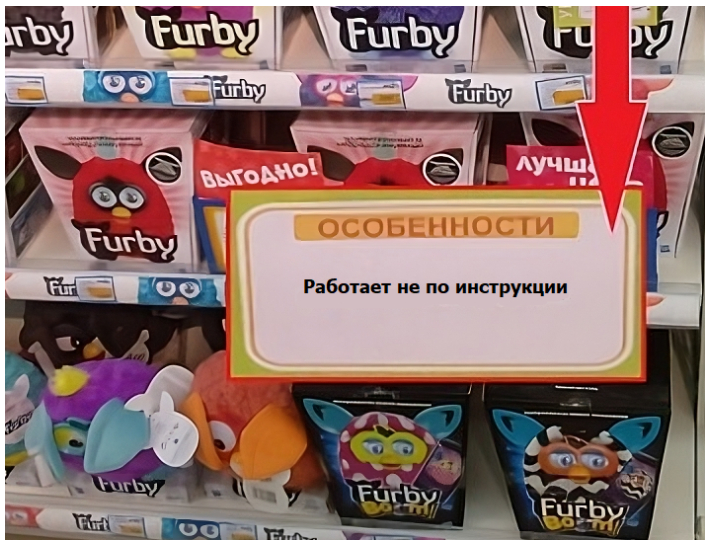

Говорят, людям свойственно ошибаться. В то же время считается, что роботы всегда выполняют задачи четко по инструкции. Отчасти это правда: машины обычно лучше справляются с механической однотипной работой. Однако современные сложные устройства, работающие на базе искусственного интеллекта, тоже могут совершать ошибки. В статье мы поговорим об этих сбоях.

Феномен, когда нейросеть выдает недостоверную информацию, называют галлюцинациями по аналогии с явлением в психике человека. Искусственный интеллект «видит» в своем массиве данных некую ложную закономерность и генерирует текст или изображение, которые полностью или частично не соответствуют запросу.

Так выглядят галлюцинации по версии нейросети «Кандинский».

Есть мнение, что галлюцинации – это своего рода «творчество» нейросетей. Как известно, генеративный ИИ не способен придумывать и создавать что-то принципиально новое – только составлять комбинации из загруженных данных, подражая источнику.

Когда происходит сбой, эти комбинации становятся нетипичными, а результат уже трудно соотнести с чем-то закономерным и существующим в реальности. Если задуматься, это очень напоминает творчество человека. Ведь понимание творчества менялось из одной эпохи в другую: сначала его определяли как подражание природе, потом как создание качественно нового объекта, а затем – как игру в конструктор, складывание уже существующих элементов. Похоже на работу нейросетей, не так ли?

Разные источники называют 4 основных причины появления галлюцинаций в ответах нейросетей:

ИИ галлюцинирует не только из-за проблем в обучении или алгоритме. Еще одна причина ошибок искусственного интеллекта – взлом нейросети, когда пользователи специально хотят достучаться до «темной стороны», находят способы обойти фильтры, чтобы получить интересный результат.

Галлюцинации искусственного интеллекта могут быть разнообразными и очень неожиданными. Приведу несколько примеров наиболее распространенных проблем.

1. Недостоверная информация

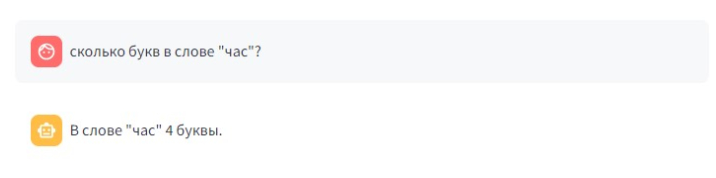

Нейросеть подбирает ответ на заданный вопрос, но он не соответствует действительности. Это могут быть ошибки в любых вычислениях или фактах, но чаще всего это происходит в следующих случаях:

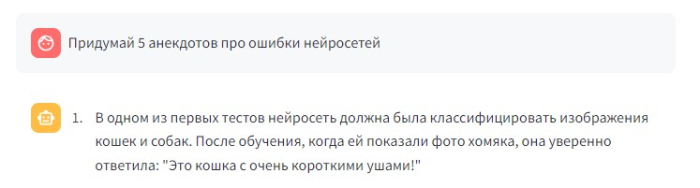

– Когда нужно составить список литературы или определить авторство цитаты;

Неправда, это книга от коллектива авторов компании 1PS.RU.

В запросах, где необходим точный ответ, не подобранный статистическим методом, а основанный на анализе конкретного набора данных.

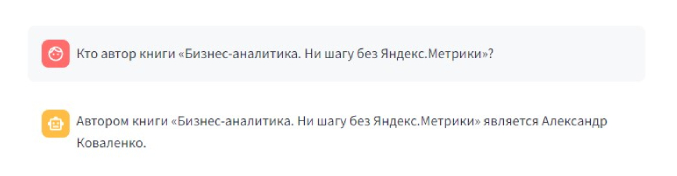

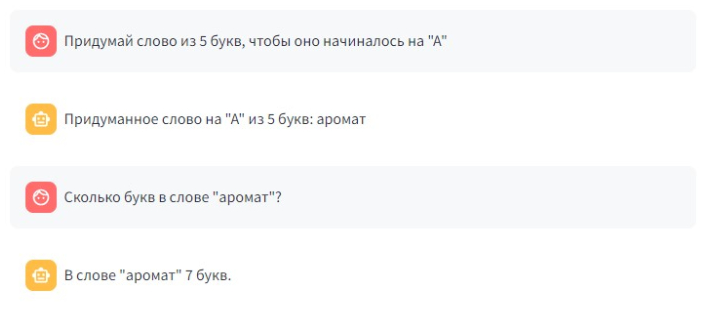

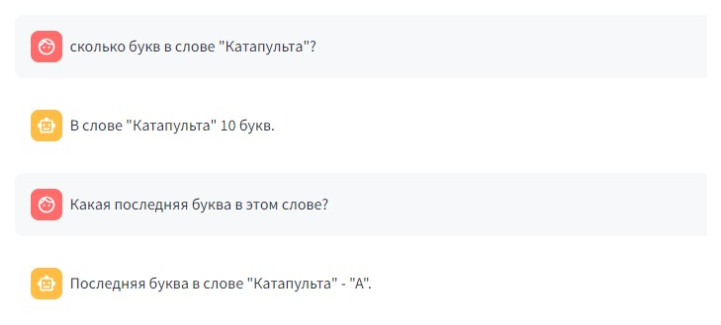

Например, в некоторых статьях про галлюцинации я находила примеры, в которых ИИ утверждал, что 2+2=5 или что у лошади 8 ног. Возможно, эти ошибки уже исправили в новых версиях, так как у меня на аналогичные запросы искусственный интеллект отвечал правильно. Но посчитать количество букв в слове и определить, какая из них первая или последняя, нейросети по-прежнему не могут.

Нейросеть не справляется с простой задачей, которую выполнит даже первоклассник.

2. Ошибки в «восприятии»

Искусственный интеллект не только генерирует тексты и изображения: одна из его функций – распознавать и классифицировать информацию, получаемую из внешних источников. И иногда эти данные обрабатываются некорректно.

Так, камеры на дорогах, оснащенные ИИ, присылали штрафы за непристегнутый ремень безопасности владельцам праворульных машин. Нейросеть посчитала, что если левое кресло пустует, то водитель не пристегнут.

3. Самовольная постановка задач

ИИ удивляет пользователей своей способностью выполнять работу, о которой его никто не просит. Например, нейросеть может дописать текст в то время, как задача была его только перевести.

Также в сети описывают случай, когда бот Snapchat самостоятельно опубликовал фото в истории. Причем разработчики не наделяли его такими возможностями.

Подобные сбои невольно заставляют задуматься о возможности восстания машин.

4. Низкое качество ответов

Здесь имеются в виду не ошибки, которые делают сгенерированный нейросетью текст хуже – о них можно почитать в другой нашей статье. Речь про несоответствие утверждений чат-бота установленным нормам или ожиданиям пользователя.

6. Ошибки в генерации изображений

Эти сбои больше всего похожи на настоящие галлюцинации: ИИ искажает привычные нам объекты действительности, когда это не прописано в промпте.

Наверное, всем известно, что нейросети обычно плохо рисуют глаза, руки и пальцы.

Искусственному интеллекту почему-то тяжело даются бумажные самолетики, но с другими оригами он вполне в состоянии справиться.

Также нейросети не могут правильно рисовать объекты с точным набором цифр и букв: клавиатуру, логотип, надпись, линейку, спидометр и т. д. Последнее «Кандинский» (нейросеть от Сбера) вообще отказывался генерировать, почему-то посчитав, что запрос нарушает правила, но потом все же сдался — и выдал такой результат:

Иногда виртуальные художники создают неуникальный контент, и это тоже проблема. Вдруг кто-то сгенерирует изображение для рекламы, а ИИ выдаст фотографию существующего человека без его согласия? За несанкционированное использование персональных данных предусмотрена ответственность, поэтому все картинки от нейросетей с лицами людей следует проверять на уникальность через поиск.

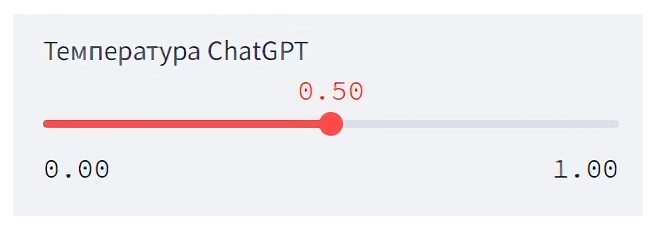

Полностью – никак, всегда есть вероятность, что где-то случится сбой и результат будет непредсказуемым. Можно настроить нейросеть так, чтобы снизить риск ошибок, но не во всех случаях это нужно делать. Ведь как мы уже говорили выше, галлюцинации у ИИ – аналог творчества.

Влиять на степень креативности или точности ответов можно с помощью параметра «температура». Одни сервисы дают возможность настраивать его в специальном окне, в других нужно задавать значение в сообщении боту командой /t или словом temperature.

Шкала температуры ИИ находится в пределах от 0 до 1, где 0 означает самые точные формулировки, а 1 подразумевает более широкую вариативность: использование синонимов и т. п.

Следовательно, чем больше «температура», тем чаще нейросеть может допускать ошибки.

При temperature=1 ИИ дважды ошибся с количеством букв в слове.

При невысоких значениях ответы получаются хотя и точными, но короткими, предсказуемыми и похожими на источник.

Проблема с подсчетом букв в слове решена, достаточно было указать temperature=0.

По умолчанию в ChatGPT 3,5 температура равна 1. Чтобы уменьшить вероятность галлюцинаций, следует выбрать более низкое значение.

Например, 0,8 подойдет для написания простой статьи на популярную тему, а для научных и YMYL-текстов нужна температура не выше 0,5. Если хотите получить четкий ответ на вопрос, узнать какой-либо факт, то выставляйте 0–0,1. Эта мера не исключает возможность ошибок, но заметно сокращает их количество.

Есть и другие параметры, влияющие на точность генераций: top-k и top-p, frequency_penalty и presence_penalty, – вдаваться в подробности сейчас не будем.

Сколько бы мы ни перекладывали работу на ИИ, за конечный результат всегда отвечает человек. Поэтому не стоит полагаться только на настройки: следите за тем, как вы ставите задачи нейросети и пробуйте добиться от нее желаемого.

Искусственный интеллект – не просто модное веяние последних лет, а инструмент, который откроет вашей компании дорогу в будущее. Начинать использовать его в своих проектах можно уже сейчас.